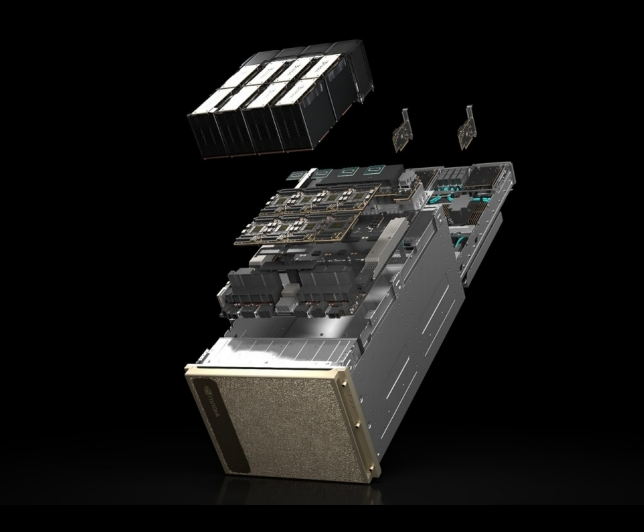

معرفی سیستمهای NVIDIA DGX H100 و DGX H200

ستون فقرات نسل جدید زیرساختهای هوش مصنوعی

با رشد انفجاری هوش مصنوعی، یادگیری عمیق و مدلهای زبانی عظیم (LLM)، نیاز به زیرساختهایی با توان محاسباتی بیسابقه بیش از هر زمان دیگری احساس میشود. NVIDIA DGX H100 و DGX H200 پاسخی مستقیم به این نیاز هستند؛ سیستمهایی یکپارچه، فوققدرتمند و آماده استفاده که برای اجرای سنگینترین بارهای کاری هوش مصنوعی طراحی شدهاند.

DGX؛ استاندارد طلایی زیرساخت AI

سری NVIDIA DGX بهعنوان مرجع (Reference Platform) هوش مصنوعی در دنیا شناخته میشود. این سیستمها تنها یک سرور قدرتمند نیستند، بلکه یک پلتفرم کامل AI شامل سختافزار، نرمافزار، شبکه و ابزارهای مدیریتی هستند که برای استفاده در دیتاسنترها، مراکز تحقیقاتی، شرکتهای بزرگ و ابررایانهها ساخته شدهاند.

مدلهای DGX H100 و DGX H200 جدیدترین نسل این خانواده هستند که بر پایه معماری NVIDIA Blackwell / Hopper توسعه یافتهاند.

قدرت محاسباتی در کلاس ابررایانه

در قلب هر سیستم DGX H100 یا H200، هشت پردازنده گرافیکی Tensor Core قرار دارد:

DGX H100:

8× NVIDIA H100 با مجموع 640 گیگابایت حافظه GPUDGX H200:

8× NVIDIA H200 با مجموع 1,128 گیگابایت حافظه GPU

این GPUها از طریق NVLink نسل چهارم و NVSwitch به یکدیگر متصل شدهاند و پهنای باندی تا 900 گیگابایت بر ثانیه بین GPUها فراهم میکنند؛ موضوعی حیاتی برای آموزش مدلهای بسیار بزرگ و توزیعشده.

طراحیشده برای کل چرخه عمر هوش مصنوعی

سیستمهای DGX H100/H200 برای پوشش تمام مراحل پردازش AI طراحی شدهاند:

تحلیل دادههای عظیم (Data Analytics)

آموزش مدلهای یادگیری عمیق (Training)

استنتاج بلادرنگ (Inference)

مدلهای زبانی بزرگ (LLMs)

بینایی ماشین، پردازش زبان طبیعی و شبیهسازیهای علمی

این سیستمها بهگونهای ساخته شدهاند که بتوانند از آزمایشگاه تحقیقاتی تا دیتاسنترهای مقیاسپذیر مورد استفاده قرار گیرند.

معماری شبکه و ذخیرهسازی در سطح دیتاسنتر

DGX H100/H200 بهصورت پیشفرض از کارتهای شبکه NVIDIA ConnectX-7 پشتیبانی میکند و قابلیت استفاده از:

InfiniBand تا 400Gbps

Ethernet تا 400GbE

پشتیبانی کامل از RDMA

را دارد. این ویژگیها باعث میشود DGX بهراحتی در خوشههای بزرگ AI و سوپرکامپیوترها ادغام شود.

در بخش ذخیرهسازی نیز:

SSDهای NVMe پرسرعت

کش داده اختصاصی

RAID سختافزاری

برای تضمین بیشترین سرعت و پایداری در نظر گرفته شدهاند.

پایداری، افزونگی و اطمینان سازمانی

DGX H100/H200 برای کار 24/7 در دیتاسنتر طراحی شده است:

6 منبع تغذیه قدرتمند با پیکربندی 4+2 Redundant

سیستم خنککنندگی صنعتی

مدیریت خارج از باند (BMC)

مانیتورینگ سلامت سیستم با NVIDIA NVSM و DCGM

این ویژگیها باعث میشوند سیستم حتی در شرایط بحرانی نیز پایدار باقی بماند.

پلتفرم نرمافزاری آماده استفاده

یکی از مزایای کلیدی DGX، ارائه آن بهصورت Pre-configured است. این سیستمها با DGX OS عرضه میشوند که شامل:

Ubuntu Server

درایورهای رسمی NVIDIA

Docker و NVIDIA Container Toolkit

ابزارهای مدیریت GPU و دیتاسنتر

پشتیبانی کامل از چارچوبهایی مانند PyTorch، TensorFlow و JAX

در نتیجه، تیمهای فنی میتوانند بدون درگیری با پیچیدگیهای نصب و تنظیم، مستقیماً روی توسعه مدلها تمرکز کنند.

چرا DGX H100 و H200 انتخاب سازمانهاست؟

بیشترین توان پردازشی در کلاس AI

یکپارچگی کامل سختافزار و نرمافزار

مقیاسپذیری آسان در سطح کلاستر

پشتیبانی سازمانی NVIDIA

کاهش زمان رسیدن از ایده به محصول (Time-to-Value)

به همین دلیل، DGX انتخاب اصلی شرکتهای پیشرو در حوزههایی مانند:

هوش مصنوعی مولد

پردازش زبان طبیعی

داروسازی و بیوانفورماتیک

خودروسازی هوشمند

مراکز تحقیقاتی و دانشگاهها

است.

جمعبندی

NVIDIA DGX H100 و DGX H200 صرفاً سرور نیستند؛ آنها زیرساخت مرجع هوش مصنوعی مدرن هستند. اگر هدف شما اجرای سنگینترین بارهای کاری AI با بیشترین کارایی، پایداری و سرعت توسعه است، DGX یکی از کاملترین و مطمئنترین گزینههای موجود در جهان به شمار میرود.